Conception de nouveaux

Produits Manufacturés.

Principe du Tolérancement capable

Avant de décrire les mécanismes du tolérancement Capable, rappelons quelques faits :

La mesure est un coût.

Il faut donc contrôler à minima et valoriser ces mesures en apportant une vision probabiliste à la qualité des performances attendues des fonctions et à la maitrise statistique des risques d’assemblage non-conforme.

Optimiser le contrôle ne peut se faire qu’en rattachant les paramètres fonctionnels à leurs besoins utilisateurs (AFB-AFT-AMDEC). Donc prendre en compte la gravité des fonctions et la propager aux paramètres fonctionnels. Cela permet de justifier pourquoi tous les paramètres ne sont pas contrôlés au même niveau de maitrise statistique.

Qui peut s’affranchir de l’usage des statistiques industrielles dans ses process de conception et de fabrication ?

Les productions qui contrôlent 100% de leurs conditions et paramètres fonctionnels, peuvent effectivement se contenter d’un calcul au pire cas pour les conditions fonctionnelles et d’un contrôle dans l’Intervalle de Tolérance (IT) pour les paramètres. Certains secteurs de l’aéronautique, spatiale ou du nucléaire produisent dans cette logique. Ne bénéficiant pas des avantages de l’usage des statistiques, ces industries sont donc à la recherche de procédés les plus précis possible. Il suffit de connaitre, par exemple, le coût d’un avion, pour comprendre que les pièces y sont fort chères.

A qui sert l’Intervalle de Tolérance ?

La probabilité de faire deux pièces strictement identiques est nulle quel que soit le procédé employé, puisque ce dernier sera la principale source de fluctuation des caractéristiques composant. Donc pour pouvoir déclarer une pièce conforme ou non-conforme la production a besoin de limites. Dès que l’on ne contrôle plus la production à 100%, mais par échantillonnage, l’usage des statistiques est impératif. Dans ce cadre, l’objectif de la production est donc de prouver que l’aptitude procédé est stable et Capable à produire les spécifications demandées. Les indicateurs normatifs statistiques pour le Long terme sont Pp ; Ppk

Qu’est-ce vraiment un Intervalle de Tolérance ?

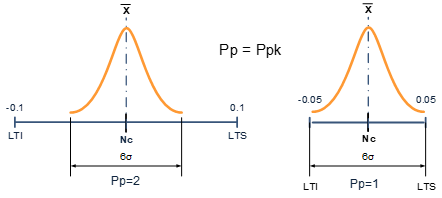

Donc un IT est lié à sa capabilité long Terme, la capabilité est définie par

![]()

Ce qui permet d’affirmer que :

± 0.1 avec un Pp=2 est la même chose que ± 0.05 avec un Pp=1

Car leurs écarts types sont les mêmes

![]()

Un IT statistique est donc un couple (IT ; Pp) ; un Intervalle de Tolérance n’a de sens que s’il est associé à sa capabilité.

Ce couple permet au bureau d’étude d’appréhender le calcul de la variation statistique des conditions fonctionnelles.

Comment ?

Par la somme quadratique des écarts types (dispersion) associé à leur taux de confiance.

Au pire cas nous aurons ITCF = ∑ (|ki|×ITcotes)

En statistique nous aurons :

![]()

Le Nominal centré de la condition fonctionnelle est obtenue par l’équation suivante :

En statistique nous aurons![]()

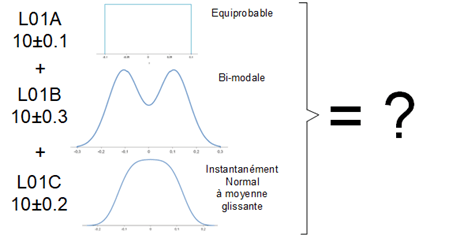

Ces formules ne sont applicables que dans le cadre de la loi normale. Malheureusement cette distribution ne s’applique que très rarement pour un Intervalle de Tolérance d’un paramètre de définition d’un produit manufacturé.

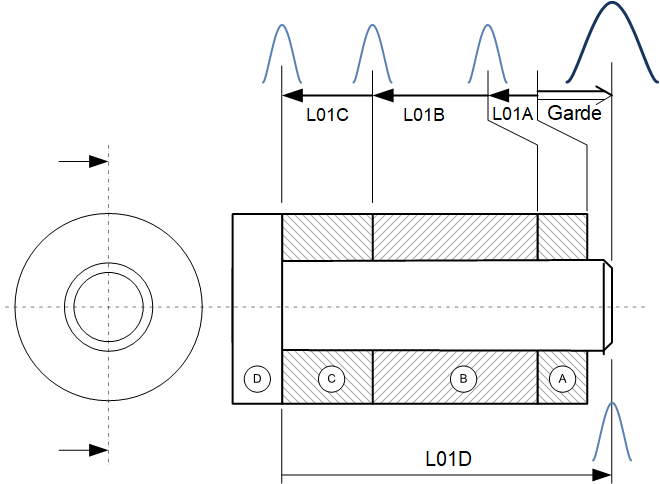

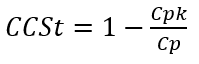

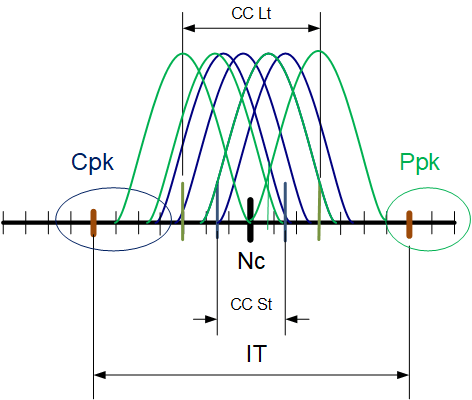

Le but du tolérancement capable est de prendre en compte le fait que la moyenne observée court terme ou long terme ne peut pas être strictement égale au Nominal Centré de la cote. Ce qui impose de prendre en compte l’excursion de la moyenne dans le calcul du Pp cible.![]()

Le décentrage Court terme est défini par le :

Le Décentrage long terme est défini par le :

![]()

Le calcul de la dispersion statistique d’un assemblage, nécessite l’utilisation d’un solveur statistique complexe tel que le propose le logiciel Design Control Power

Résumons-nous :

- Un IT doit être associé à sa capabilité

- La définition d’un IT de Bureau d étude n’est pas gaussien

- Il faut un outil logiciel pour effectuer ces calculs, comme le montre l’exemple ou les IT proviennent de procédés différents donc de lois statistiques différentes.

Attention, demander un centrage très précis pour essayer de rester dans une position gaussienne pour les calculs des assemblages, a un impact important sur les coûts des outillages.

Un IT est avant tout déterminé par la dispersion intrinsèque du procédé retenue et non par l’imagination du concepteur.

La mise en place du calcul statistique dans la détermination prévisionnelle de la dispersion des balises fonctionnelles permet des gains significatifs sur le coût et le délai de vos produits, car raisonner pire cas et contrôler à 100% génère des coûts prohibitifs.

La mise en place d’une stratégie de Tolérancement Capable, comme cela a été vu dans les précédent articles, permet de connaitre au plus tôt les cibles des nominaux centré, donc réduire le risque de modification d’outillage surtout dans le cadre d’outillage multi-empreintes, un gain de temps et d’argent garanti.

Les techniques que nous avons élaborées, sont dans la continuité logique des travaux de la norme HCPP. Ce qui signifie que l’observation de la capabilité des procédés est primordiale pour la détermination des nominaux et la maitrise du Design Space (zones fonctionnelles garanties du produit)

Pour mettre en place une politique de Tolérancement Capable dans votre entreprise, Vous avez besoin de déterminer la valeurs attendue des indicateurs en garantissant leurs cohérences, Long terme et court terme. Nous vous proposons de vous engager avec nous dans cette démarche afin de garantir la maitrise de vos couts, de vos délais et bien sûr de votre qualité.